Eficiência de ferramentas para desmascarar vídeos falsos deixa a desejar, mostra estudo

Informações falsas disseminadas por deepfakes já afetaram autoridades, celebridades e até o Papa. Levantamento avaliou 89 das mais novas técnicas empregadas para apontar adulterações digitais em vídeos e encontrou lacunas significativas no desempenho. Falta de bases de dados diversificadas e padronizadas é uma das limitações para aperfeiçoamento da tecnologia

Por Malena Stariolo

Dráuzio Varella é um dos comunicadores de saúde mais conhecidos no país. Seu trabalho de divulgar e comentar informações de cunho médico e científico ganhou destaque nacional ao ser veiculado em um quadro fixo no programa Fantástico, da Rede Globo. Tendo em paralelo a ampla audiência que passou a acompanhá-lo por meio das redes sociais, Varella é hoje uma referência popular para assuntos que envolvam o conhecimento de temas de saúde e bem-estar.

Pode-se imaginar, então, o impacto que houve no público que o segue nas redes sociais quando começou a circular um vídeo no qual Dráuzio Varella aparecia recomendando os benefícios de um produto milagroso para manter a pele jovem e bonita. Originalmente publicado no TikTok, o vídeo rapidamente se espalhou nas outras redes sociais. E teria continuado a se espalhar, não tivesse o próprio Dráuzio Varella vindo a público explicar que, ainda que o vídeo exibisse o rosto do médico, e se pudesse observar as palavras elogiosas saindo de sua boca, tratava-se de uma fraude, feita utilizando-se tecnologias de IA. Varella foi mais uma vítima dos chamados vídeos deepfakes.

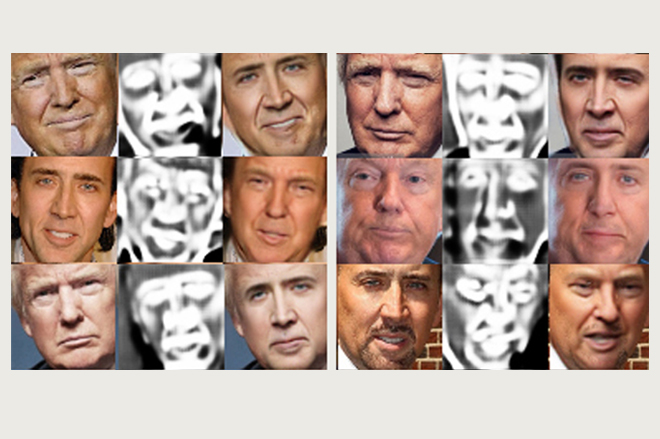

Segundo o grupo de pesquisas da Google, essa técnica surgiu pela primeira vez no final de 2017 e consiste em usar modelos de inteligência artificial generativa para manipular vídeos ou áudios. O termo, que combina “deep”, fazendo alusão à técnica de deep-learning (aprendizado profundo), e “fake”, de “falso”, passou a ser usado publicamente no mesmo ano, por conta de um tópico de discussão intitulado “deepfakes”, criado na plataforma Reddit. O moderador do fórum começou a utilizar a tecnologia para inserir o rosto de celebridades em vídeos pornográficos e publicar os vídeos falsos no tópico criado.

Embora a técnica também seja utilizada para a produção de obras descontraídas e bem-humoradas — como uma imagem, que viralizou na internet em 2023, na qual se via o Papa Francisco usando uma jaqueta estilo puffer — o grau de verossimilhança alcançado pelas ferramentas de geração de deepfakes, somado à crescente facilidade de acesso a esse tipo de tecnologia, têm gerado amplas discussões sobre segurança cibernética e processos de regulamentação para o uso de Inteligências Artificiais generativas, dadas as potenciais ameaças à privacidade, aos processos democráticos e à economia.

Para contribuir com este debate, pesquisadores da Unesp conduziram uma pesquisa para analisar as ferramentas mais recentes empregadas para a detecção de deepfakes. Segundo Kelton Augusto Pontara da Costa, pesquisador do Departamento de Computação da Unesp, campus Bauru, a principal motivação do estudo foi identificar as limitações e desafios das principais técnicas de detecção desses vídeos e imagens, a fim de incentivar o seu aperfeiçoamento.

O potencial dessas ferramentas para gerar fraudes foi evidenciado em um vídeo feito pelo diretor norte-americano Jordan Peele, que transferiu seus próprios movimentos faciais para o rosto de Barack Obama empregando a tecnologia de deepfake. No vídeo, produzido em 2021, vê-se o ex-presidente dos Estados Unidos alertar para os perigos da desinformação e das fake news, sem que, no entanto, Obama nunca tenha proferido esta fala.

“A facilidade de acesso à produção de deepfakes levanta uma preocupação social e ética significativa. Conteúdos manipulados, como discursos adulterados de figuras públicas ou a criação de vídeos falsos de pessoas conhecidas, têm um impacto potencialmente desestabilizador na sociedade. As implicações podem ser múltiplas, indo da erosão da confiança pública até a amplificação de desinformação em larga escala”, afirma Costa, que é um dos autores do artigo.

Ferramentas ainda são pouco treinadas

O grupo de pesquisadores analisou 89 artigos, publicados entre 2018 e 2024, que descreviam diferentes ferramentas empregadas para identificar vídeos suspeitos de serem deepfakes. O levantamento é o mais extenso: um trabalho anterior, formulado por outro grupo, cobriu os anos de 2018 e 2023 e analisou 66 artigos. Os resultados do estudo foram apresentados no artigo A Review of Deep Learning-based Approaches for Deepfake Content Detection, publicado na revista científica Expert Systems.

Os pesquisadores ficaram surpresos ao constatar a grande diversidade de metodologias que estão sendo empregadas para a detecção de deepfakes. “Os métodos vão desde abordagens baseadas em redes neurais convolucionais (CNNs) até redes recorrentes (RNNs) que exploram diferentes nuances dos vídeos”, afirma Costa.

Algumas CNNs, por exemplo, quando aplicadas em vídeos, não analisam o movimento do vídeo, mas fazem uma varredura frame a frame, buscando inconsistências em imagens congeladas. Elas foram projetadas para detectar distorções específicas, como problemas de alinhamento facial ou interferências na imagem. Já as RNNs analisam o movimento do vídeo e conseguem detectar falhas na sincronização labial, ou movimentos faciais inconsistentes.

Embora usuários de ambas as metodologias afirmem obter índices de até 99% de acerto, a depender das técnicas envolvidas, o grupo verificou que estes resultados não são plenamente válidos. “Nós vimos que os dados utilizados para treinar os modelos apresentam uma lacuna: não são padronizados e têm pouca diversidade”, diz Costa. “Esse é um achado significativo porque a disponibilidade limitada de conjuntos de dados bem construídos limita o desenvolvimento e a avaliação imparcial de novas técnicas.”

Ou seja, embora a precisão das técnicas possa beirar os 99% na etapa de treinamento das ferramentas, que envolve a análise de bases de dados específicas, essa acurácia tende a cair quando elas são aplicadas em situações reais.

Como superar as limitações?

Para Costa, dispor de uma boa base de dados é um dos três principais pilares para que se possa desenvolver um método eficaz na detecção de deepfakes. “É essencial termos conjuntos de dados diversificados que capturem a complexidade das deepfakes modernas, permitindo que os detectores aprendam a identificar padrões sutis”, diz. Essa diversidade, entretanto, não foi encontrada nas principais bases utilizadas pelas ferramentas, o que indica um caminho em aberto que deve ser percorrido com o objetivo de aprimorar as técnicas existentes. Os outros dois pilares envolvem o avanço das arquiteturas híbridas de aprendizado profundo e o uso de abordagens como aprendizado não supervisionado e semisupervisionado.

As arquiteturas híbridas envolvem a criação de sistemas que combinam diferentes métodos como, por exemplo, a criação de uma técnica que aplique tanto princípios de CNNs, para imagens estáticas, como também das RNNs, para análises em movimento. Isso permite que as lacunas de um método sejam supridas pelo outro, gerando ferramentas mais complexas e adaptáveis a diferentes situações, sem perder sua eficiência.

Apesar de promissora, a criação de arquiteturas híbridas esbarra em uma série de dificuldades. Entre elas, o alto custo computacional necessário para conseguir processar modelos tão complexos. E a criação de um sistema que opere corretamente a partir da combinação de diferentes técnicas demandaria um vasto conjunto de dados para serem treinadas – o que ainda não existe.

Nesse sentido, o grupo aponta como alternativa para superar a falta de bases de dados robustas, o uso de sistemas de aprendizado não supervisionado e semisupervisionado.

As técnicas não supervisionadas se concentram em identificar padrões anômalos em dados desconhecidos, o que pode ser útil para detectar deepfakes sem a necessidade de grandes conjuntos de treinamento. “Nesse método nós não temos informação do rótulo, que seria o equivalente a uma categoria”, explica João Paulo Papa, que também participou do artigo.

O docente da Faculdade de Ciências da Unesp, campus Bauru, usa como exemplo um grupo de imagens médicas; algumas estão marcadas como “apresentando a doença” e outras como “saudáveis”. “Com isso, diz-se que o dado está rotulado, ou seja, a IA ser informada quanto à natureza da informação que ela está recebendo. Por exemplo, se são imagens de doença ou não”, diz. A vantagem do método não supervisionado é que a própria ferramenta busca por padrões dentro de uma grande quantidade de informações e, a partir dessa busca, ela identifica possíveis rótulos. “Já as metodologias semisupervisionadas utilizam uma combinação de dados conhecidos e desconhecidos para treinar e melhorar os modelos”, afirma Papa.

Embora essas abordagens esbarrem em alguns desafios técnicos, como a necessidade de uma elevada capacidade computacional, o estudo identificou-as como promissores pontos de partida para pesquisas futuras, pois permitem criar modelos mais flexíveis, escaláveis e generalizáveis. “Esses métodos são muito úteis para detectar anomalias, ou seja, quando algum material apresenta características muito diferentes daquelas que foram usadas no seu treinamento”, diz Papa, “porque conseguem identificar que se trata de um novo conjunto de dados e não tentam encaixar esses dados dentro das classes ou dos rótulos que ela já aprendeu”, diz.

“Juntos, esses métodos são essenciais para a criação de detectores versáteis que possam responder de forma ágil à evolução das técnicas de deepfake”, completa Costa.

A corrida entre os fraudadores e as ferramentas de detecção

A capacidade de adaptação e evolução se torna particularmente urgente em um cenário no qual as tecnologias de deepfake evoluem de maneira mais rápida do que os métodos para sua identificação. Gerar conteúdo falso é mais fácil porque as técnicas empregadas nessa ação usam as chamadas Redes Generativas Adversariais (GANs). Elas funcionam com duas redes neurais: uma cria os conteúdos e a outra avalia se parecem reais ou falsos, o que as faz melhorar constantemente. “É uma competição que permite que o sistema aprenda e se adapte rapidamente às falhas, resultando em falsificações cada vez mais realistas”, explica Costa.

Enquanto os modelos para produzir falsificações funcionem independentemente de bancos de dados variados, ou de outras ferramentas, os métodos de detecção enfrentam desafios complexos porque precisam ser capazes de reconhecer manipulações que são apresentadas em diferentes contextos, e gerados por diferentes estratégias.

“É como se o deepfake estivesse sempre um passo a frente”, afirma Papa. Assim, técnicas que funcionam bem para alguns tipos de deepfake não são tão efetivas para outros. “Cada novo tipo de deepfake demanda que os detectores se adaptem e identifiquem padrões antes desconhecidos. Isso exige grande esforço de generalização e adaptação. Além disso, a detecção de deepfakes precisa considerar os diversos cenários e condições reais, o que aumenta a complexidade”, diz Costa.

Partindo desta avaliação, os autores destacam a importância de aperfeiçoamento das técnicas já existentes, tanto por meio de combinações como a partir da criação de bancos de dados mais completos. Também chamam a atenção para a necessidade de implementar políticas regulatórias, assim como de incentivar colaborações multidisciplinares, a fim de lidar com os diferentes aspectos, tecnológicas, sociais e éticos, envolvidos nesta tarefa.

Este texto é uma reprodução livre de artigo publicado pelo Jornal da Unesp - https://jornal.unesp.br/

Artigos e comentários de autores convidados não refletem, necessariamente, a opinião da revista Interesse Nacional